퀄컴 테크날러지(Qualcomm Technologies Inc.)와 메타(Meta)는 메타의 라마 2(Llama 2) 대형 언어 모델(LLM)을 클라우드에만 의존하지 않고 온디바이스에서 실행할 수 있도록 최적화할 예정이라고 19일 밝혔다.

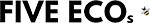

라마 2와 같은 생성형 AI 모델을 스마트폰, PC, VR/AR 헤드셋, 차량 등의 온디바이스에서 실행함으로써 개발자들은 클라우드 비용을 절감할 뿐만 아니라 이용자들에게 개인적이고 신뢰할 수 있고 맞춤화된 경험을 제공할 수 있다.

이에 퀄컴은 새롭고 흥미로운 AI 애플리케이션 제작이 가능한 라마 2 기반의 온디바이스 AI 구현이 가능하도록 지원할 예정이다. 이로써 고객과 파트너, 개발자들은 지능형 가상 비서 및 생산성 애플리케이션, 콘텐츠 제작 도구, 엔터테인먼트 등의 사용 사례를 구축할 수 있다. 스냅드래곤으로 구동되는 이러한 새로운 온디바이스 AI 경험은 인터넷 연결이 없는 곳에서나 비행기 모드에서도 사용이 가능하다.

메타와 퀄컴은 기술 혁신을 주도하고 최고의 기기 경험을 제공하기 위해 오랫동안 협력해왔다. 라마 생태계를 확장하기 위한 양사의 협력은 연구 및 제품 엔지니어링 노력 전반에 걸쳐 있으며, 퀄컴의 온디바이스 AI 리더십은 라마 생태계 확장에 중요한 역할을 하고 있다.

퀄컴은 2024년부터 스냅드래곤 기반 단말기에 라마 2 기반 AI 구현이 가능하도록 지원할 예정이다. 개발자들은 퀄컴 AI 스택을 활용해 온디바이스 AI 애플리케이션을 최적화할 수 있다. 퀄컴 AI 스택(Qualcomm® AI Stack)은 스냅드래곤에서 AI를 더 효율적으로 처리하여 얇고 가벼운 소형 기기에서도 온디바이스 AI 구현을 가능하게 하는 전용 도구 모음이다. 관련 최신 정보는 퀄컴의 월간 개발자 뉴스레터 구독을 통해 확인할 수 있다.